El Nobel de Física 2024 fue concedido a John J. Hopfield y Geoffrey E. Hinton “por descubrimientos e invenciones fundamentales que permiten el aprendizaje automático con redes neuronales artificiales”, lo cual ha sido celebrado, por la importancia que ha cobrado la inteligencia artificial, pero también criticado porque no está claro dónde está la física en el desarrollo.

A partir del comunicado de la Real Academia de Ciencias de Suecia se puede ver que anticiparon esta crítica y que trataron de atajarla, de hecho, el texto se titula “Usaron física para encontrar patrones en la información”.

“Los galardonados de este año utilizaron herramientas de la física para construir métodos que ayudaron a sentar las bases del poderoso aprendizaje automático actual”, es la primera frase del comunicado de la fundación Nobel; sin embargo, esto no fue suficiente para acallar críticas y memes. Saber quién tiene razón en este debate es más complicado de lo que parece.

Base biológica

La idea central de la que partió el desarrollo del campo del aprendizaje automático la publicó en 1949 el ahora considerado pionero de la biopsicología, Donald Holding Hebb (Nueva Escocia,1904-1985), en su libro The Organization of Behavior: A Neuropsychological Theory (La organización del comportamiento: una teoría neuropsicológica), donde sugiere que el aprendizaje se produce porque las conexiones entre neuronas se refuerzan cuando trabajan juntas y se debilitan cuando dejan de hacerlo.

Así, cuando iniciaron los intentos de recrear el funcionamiento de la red cerebral mediante la construcción de redes neuronales artificiales con simulaciones computarizadas se procuró imitar a las neuronas por medio de nodos y a las sinapsis por conexiones entre los nodos que pueden hacerse más fuertes o más débiles.

“La hipótesis de Donald Hebb todavía se utiliza como una de las reglas básicas para actualizar las redes artificiales mediante un proceso llamado entrenamiento”. Comunicado de la Academia de Ciencias de Suecia.

Hopfield, el físico

Como físico, a John Hopfield le interesaban los problemas teóricos en biología molecular. “Cuando lo invitaron a una reunión sobre neurociencia, se encontró con investigaciones sobre la estructura del cerebro. Quedó fascinado por lo que aprendió y comenzó a pensar en la dinámica de las redes neuronales simples”, señala la Academia.

Su interés llegó al grado de que en 1980, Hopfield dejó su puesto en la Universidad de Princeton y a sus colegas en física, y aceptó la oferta de una cátedra de química y biología en el Instituto de Tecnología de California (Caltech), donde “tenía acceso a recursos informáticos que podía usar para experimentar libremente y desarrollar sus ideas sobre redes neuronales”.

Ahí pudo hacer su primera red neuronal de software que simulaba nodos y conexiones “utilizando la física que describe cómo se desarrollan los materiales cuando los espines (de las partículas subatómicas) se influyen entre sí”, añade el comunicado.

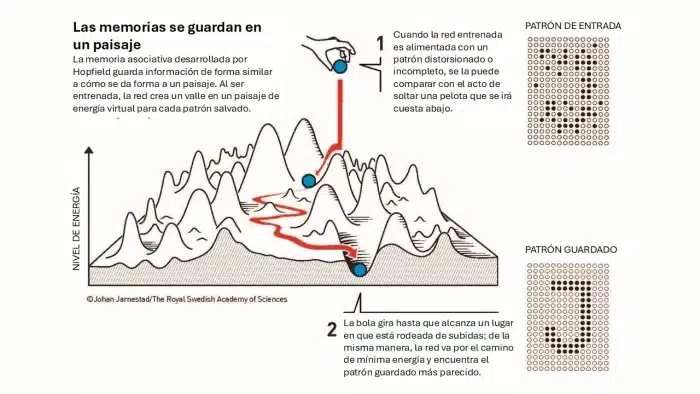

La red de Hopfield reconoce patrones gracias a que revisa el recorrido de la información por los nodos uno por uno y ajusta las conexiones calculando el camino de mínima energía. Así, si la energía calculada se puede reducir cambiando un píxel negro a blanco se cambia el color.

“Este procedimiento continúa hasta que es imposible encontrar más mejoras. Cuando se llega a este punto, la red a menudo ha reproducido la imagen original en la que se entrenó”. Aunque no se entrena con un solo patrón sino con muchos.

Entendimiento con física estadística

En 1982, cuando Hopfield publicó su artículo sobre la memoria asociativa, Geoffrey Hinton estaba en la Universidad Carnegie Mellon de Pittsburgh tratando de aplicar sus estudios en psicología experimental e inteligencia artificial a la pregunta de “si las máquinas podrían aprender a procesar patrones de forma similar a los humanos, encontrando sus propias categorías para clasificar e interpretar la información”.

Categorizar o interpretar una imagen es un proceso más complejo que distinguir una forma. Este proceso, uno de los más importantes de la inteligencia, es el que desde muy temprano en la infancia nos permite distinguir a diversos animales como perros, aunque tengan formas y tamaños distintos, y distinguirlos de los gatos y las ardillas.

Para poner la categorización en una máquina, Hinton, junto con Terrence Sejnowski, “partió de la red de Hopfield y la amplió para construir algo nuevo, utilizando ideas de la física estadística”, explica la Academia Sueca.

Esa disciplina, también llamada mecánica estadística, inició en el siglo XIX, cuando el físico Ludwig Boltzmann partió de considerar las probabilidades de que las múltiples moléculas de un gas estuvieran en distintos estados energéticos y construyó un andamiaje matemático con el que llegó a entender las relaciones entre la energía, el calor y la entropía que había encontrado la termodinámica estudiando las máquinas de vapor.

“Es difícil, o imposible, rastrear todas las moléculas separadas en el gas, pero es posible considerarlas colectivamente para determinar las propiedades generales del gas, como la presión o la temperatura”. Real Academia de Ciencias de Suecia

Hinton utilizó la matemática de Boltzmann para crear una red, a la que llamó Máquina de Boltzmann, que optimiza los valores para encontrar rutas de mínima energía como la de Hopfield, pero se distingue porque la Máquina alcanza un estado en que “el patrón de los nodos puede cambiar, pero las propiedades de la red en su conjunto siguen siendo las mismas”.

Esto hace que la Máquina de Boltzmann sea un ejemplo temprano de Inteligencia Artificial generativa, que puede aprender, no a partir de instrucciones, sino de ejemplos; además, una vez entrenada “puede reconocer rasgos familiares en información que no ha visto anteriormente”, concluye la Academia.

Epílogo

Todo eso está muy bien, pero “seamos honestos: el desarrollo de software no es lo que tradicionalmente consideramos física”, dice Sabine Hossenfelder, quien tiene un canal de YouTube dedicado a, sobre todo, analizar críticamente los fundamentos de la física.

Sin embargo, Hossenfelder admite en su video al respecto, que entre las disciplinas que obtienen premios Nobel, la física fue posiblemente el área más cercana a la Inteligencia Artificial, así que tiene sentido que el Comité del Nobel haya dado el premio en esa categoría.

“Pero esto también nos dice cuán terriblemente atrasado está el comité del Premio Nobel en la concesión de premios –añade la experta–, porque no es como que las redes neuronales o el aprendizaje automático sean algo nuevo… Simplemente no se les ocurrió otorgar un premio por ello hasta que todos usaban ChatGPT”.

Este premio también “nos dice que no había ningún tema en la física real que fuera remotamente comparable en relevancia”, añade Hossenfelder, y como a la física y comunicadora le gusta hacer lo que llama “chistes bobos”, concluye: “Así que, por favor, discúlpenme, ahora tengo que irme y llorar en silencio sobre mi libro de texto de mecánica cuántica”.